La fin de l’année a été riche en annonces chez les éditeurs de logiciels photos. Toutes ont en commun d’avoir été plus ou moins discrètement taguées « Intelligence Artificielle », à mi-chemin entre l’univers dystopique de la série Black Mirror et la promesse de nous libérer du temps pour plus de créativité.

Intelligence Artificielle et traitement de l’image en photographie, qu’en est-il vraiment, menons l’enquête.

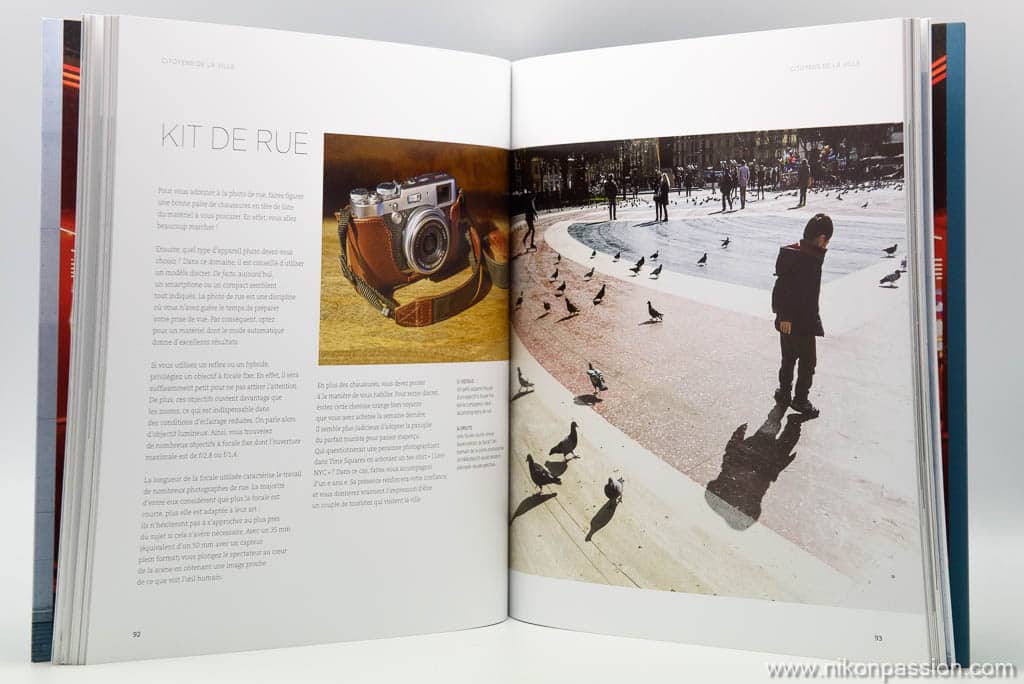

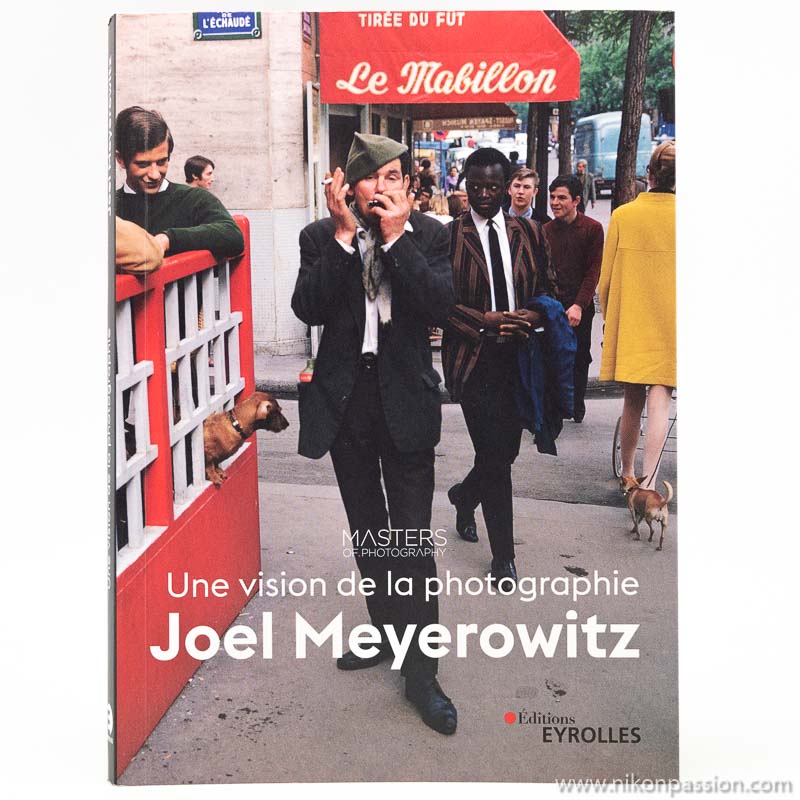

Le livre de Jacques Croizer via Amazon

Le livre de Jacques Croizer via la FNAC

Cet article vous est proposé par Jacques Croizer. Déjà à l’origine de plusieurs articles sur Nikon Passion dont un sur l’IA pour les photographes, Jacques Croizer est surtout l’auteur d’un guide qui simplifie la technique photo au profit du plaisir de photographier, « Tous photographes, 58 leçons pour réussir vos photos« .

Intelligence artificielle et traitement de l’image (IA)

En poussant un peu loin le bouchon (de l’objectif), nous pourrions dire que le rêve de Leibniz est l’acte fondateur de l’intelligence artificielle : toute idée complexe peut être décomposée en idées plus simples, jusqu’à aboutir à une combinaison d’idées axiomatiques. (De Arte combinatoria – Leibniz 1666).

C’est plus sérieusement dans les années 50 qu’émerge l’idée qu’une machine puisse être capable de réaliser une tâche relevant jusqu’ici de l’intelligence humaine, par exemple tenir une conversation (test de Turing). Mais le chemin est long du projet à la chose.

Si une intelligence artificielle sait traduire d’une manière plus ou moins compréhensible la plupart des écrits de l’humanité, elle est encore très loin de pouvoir les résumer correctement, sans parler d’y ajouter la moindre page. L’intelligence humaine reste le carburant dont elle ne peut se passer. C’est sans doute pourquoi certains experts préfèrent parler d’intelligence augmentée que d’intelligence artificielle, remettant ainsi l’humain au cœur du processus de création.

Intelligence artificielle et création d’image

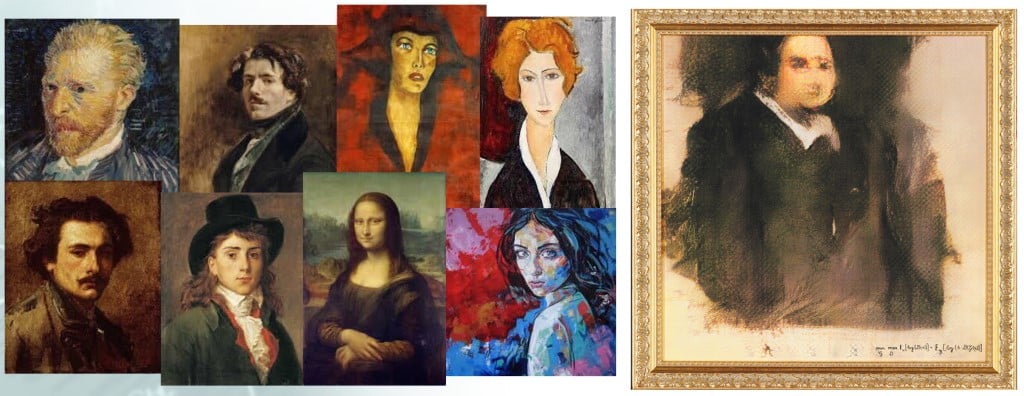

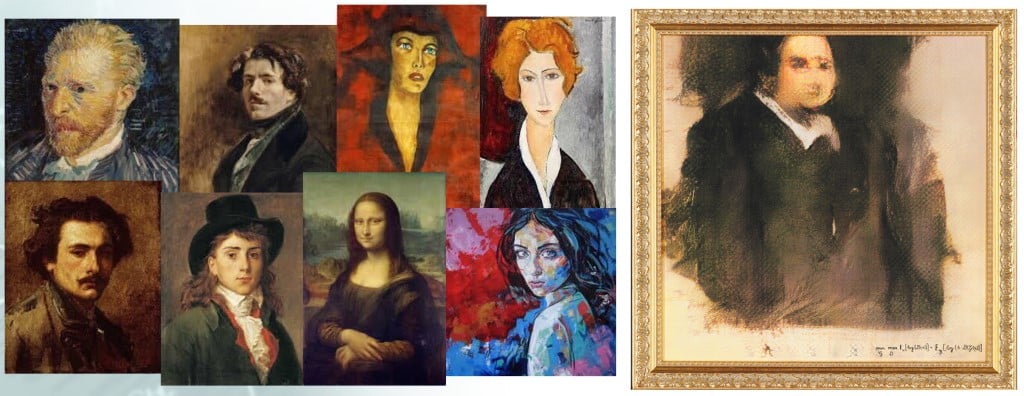

Qu’en est-il de l’image ? Un logiciel peut très facilement produire en quelques clics une illustration abstraite, mais imaginez-vous votre ordinateur capable de dessiner, ex nihilo, ne serait-ce que l’ébauche d’un portrait ?

Vraisemblablement oui, à en croire celui présenté à droite dans l’illustration ci-dessous… mais à vrai dire, ce visage n’est pas sorti de nulle part : le collectif Obvious, à l’origine de ce travail, a entraîné un algorithme à peindre, en utilisant pour base de connaissances une collection de portraits classiques, réalisés entre le XIVème et le XIXème siècle.

Edmond De Belamy (C) Obvious Art

L’algorithme se compose de deux réseaux de neurones artificiels : un générateur (le peintre) et un discriminateur (le critique d’art).

A mesure qu’il s’entraine, le générateur crée des images de plus en plus réalistes. Le discriminateur sélectionne parmi les œuvres ainsi produites celles qu’on ne saurait attribuer ni à un humain, ni à une machine. Dans cette présélection, les auteurs du logiciel (de vrais humains !) ont finalement choisi onze tableaux, constituant la généalogie imaginaire de la famille Bellamy.

La technologie (DCGAN) à la base de cet exploit est l’un des développements les plus récents de ce qu’il est convenu d’appeler « l’apprentissage profond » ou « deep learning » (à la base de la réduction de bruit DeepPRIME de DxO Photolab 4, voir plus bas).

Dans la phase d’apprentissage, le générateur est présumé pouvoir extraire de l’ensemble des œuvres qu’on lui a données à digérer une grammaire suffisante pour qu’il puisse à son tour créer de manière autonome de nouvelles toiles.

Le photographe passionné que vous êtes s’étonnera sans doute que cette grammaire ait pu si délibérément ignorer les règles basiques de composition : le personnage est placé très haut dans le cadre ! Peut-être est-ce lié au fait que les réseaux de neurones convolutifs du générateur analysent l’image en la découpant en fragments qui se chevauchent, donc sans jamais en avoir une vision globale ?

On préfèrera retenir que l’algorithme aurait pu tout aussi bien dessiner un mouton, une chaise ou une locomotive, ou tout simplement n’imprimer qu’une grosse tache multicolore. Il a pourtant bel et bien réalisé le portrait d’une personne qui n’existe pas ! C’est là l’exceptionnelle performance du procédé.

Pour la petite histoire, sachez que cette œuvre a été adjugée pour la modique somme de 432.500 $ ! Une question en passant : qui est l’auteur du tableau ? Le collectif qui a créé l’algorithme ou l’algorithme lui-même ? Ce dernier est-il seulement capable d’intention ?

IA et développement du fichier RAW

Exceptée la précédente expérimentation, la création d’image reste encore l’apanage des peintres et photographes. Les premiers interprètent à leur guise la réalité, tandis que les seconds, du moins dans leur rôle de témoin de notre temps, essaient de la retranscrire aussi fidèlement que possible.

Nos boîtiers ne fournissent malheureusement souvent que des images imparfaites. L’étape de développement du fichier RAW, à l’aide d’un logiciel spécialisé, est incontournable à qui veut magnifier sa production.

Bien qu’utilisant au maximum les Picture control (chez Nikon) à la prise de vue afin d’optimiser le développement de leurs fichiers RAW, beaucoup de photographes trouvent encore cette phase de travail trop chronophage. Où est le temps où ils se contentaient de prendre la photo, le tireur se chargeant ensuite de la retranscrire au mieux sur le papier ?

Si au moins leur logiciel de développement préféré était capable de restituer en un seul clic la réalité, libre à eux de tirer ensuite sur les curseurs pour aboutir à une version plus personnelle. Les photographes ne demandent pas à l’IA de créer une image, mais seulement de l’améliorer … automatiquement ! Facile ?

L’apprentissage profond (deep learning) sait se rendre utile sur des créneaux bien délimités : le service de généalogie myheritage propose par exemple un utilitaire de colorisation automatique de vos anciennes photos. D’après les indications du site « le modèle a été formé à l’aide de millions de vraies photos et a développé une compréhension de notre monde et de ses couleurs ». Le résultat, proche des cartes postales aux couleurs fanées de l’ancien temps, est impressionnant.

La piste est prometteuse, mais pour développer n’importe quel fichier RAW, une telle intelligence devrait au préalable être entraînée sur une très grande variété d’images parfaitement traitées, en se référant à une réalité qui n’est tout simplement pas mesurable. En l’absence de données d’apprentissage, il est clair que le deep learning ne nous sera d’aucun secours.

Les logiciels de post traitement utilisent donc des techniques d’intelligence artificielle qui ont fait leurs preuves depuis bien des années : comparez les résultats des corrections automatiques (tonalité, contraste et couleur) de la version actuelle de Photoshop CC avec ceux d’une version vieille de 10 ans : les différences sont marginales.

Ces traitements sont basés sur les statistiques élémentaires de l’image, en particulier sur les histogrammes de ses différentes couches. Les améliorations apportées à la plage tonale de l’image se font sans aucune contextualisation. C’est sans doute parce que le jeu n’en vaut plus la chandelle : les résultats obtenus sont suffisamment convaincants, en témoigne l’avant/après présenté ci-dessous.

Yéyette (f/5.6 à 1/250 s) photo (C) Philou

Mission accomplie aurions-nous tendance à penser… seulement voilà, la justesse de la correction dépend beaucoup des spécificités de la photo d’origine. En particulier, le traitement automatique des couleurs relève encore trop aujourd’hui de la loterie, lorsque la prise de vue s’éloigne un peu des standards.

Quoiqu’il en soit, il n’y a pas de quoi fouetter un chat, comme le disait Yéyette, ni bien sûr de quoi faire apparaitre si soudainement le tag « intelligence artificielle » dans les arguments de vente de ces logiciels. Alors ?

IA et post traitement spécifique

Nous avons vu que les réseaux de neurones convolutifs ont encore un peu de mal à générer une image complexe. Ils sont par contre passés maîtres dans l’art de les classer.

L’exemple du Challenge ILSVRC est parlant. Les logiciels participants au challenge sont entraînés en mode supervisé sur une base d’apprentissage de 1.200.000 illustrations labellisées : parmi 1.000 références possibles, on indique pour chaque image le sujet qu’elle contient, avion, voiture, personne, etc. Les logiciels doivent ensuite reconnaitre ces objets dans 50.000 images qu’ils n’ont jamais vues auparavant.

En 2010, le taux d’erreur était de 28 % : une image sur 4 était mal reconnue. Les progrès du deep learning ont été si rapides qu’en 2015, le taux d’erreur de l’algorithme avait chuté en dessous de celui obtenu par des humains (< 5%). Relativisons toutefois la performance : nous sommes capables de reconnaitre bien plus que 1.000 catégories d’objets !

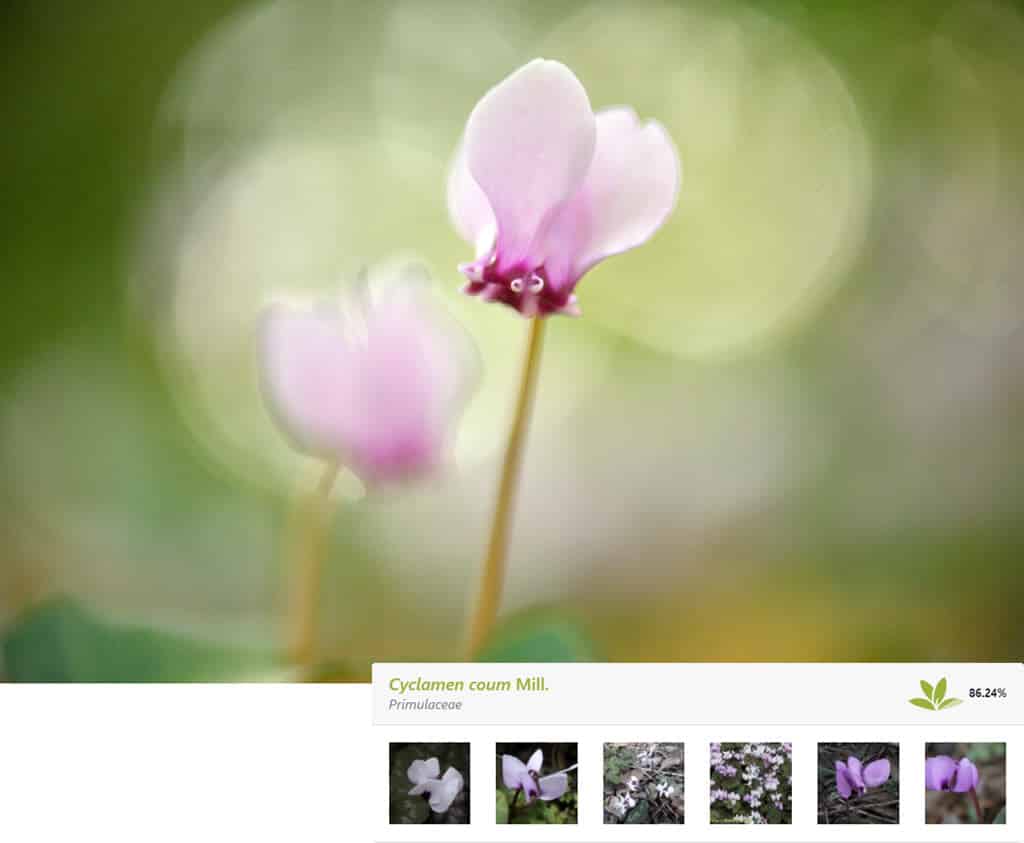

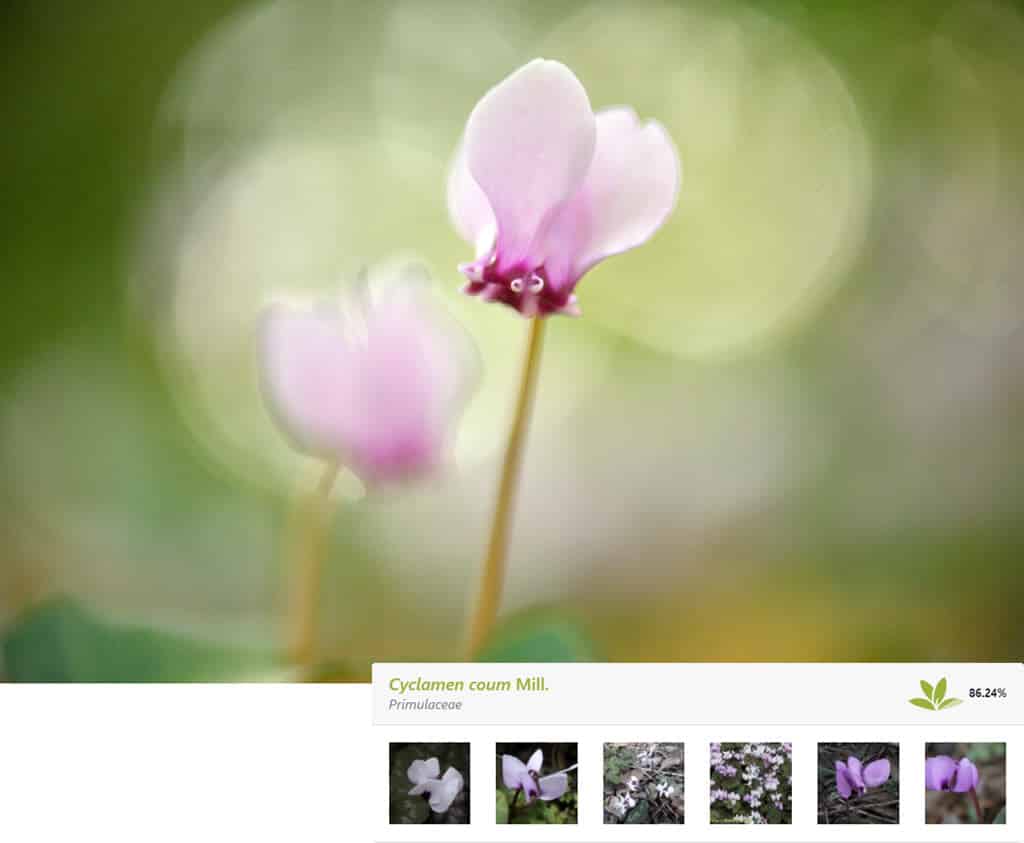

Une fois encore, il suffit de réduire le périmètre d’apprentissage à un contexte particulier pour obtenir des performances pour le moins bluffantes. L’application Plantnet est ainsi capable de reconnaitre une plante parmi près de 30.000 espèces, après que vous l’ayez simplement photographiée avec votre smartphone. Qui dit mieux ?

Cyclamen (f/3.5 à 1/320 s – 105 mm Nikon) photo (C) J. Croizer

Luminar AI (Artificial Intelligence) s’auto décrit comme étant « le premier logiciel de retouche photo entièrement optimisé par intelligence artificielle ». Il utilise cette faculté de classification automatique pour proposer des traitements adaptés à chaque sujet.

Par exemple, le logiciel identifie automatiquement la photo ci-dessous comme étant celle d’un paysage. A partir de son fichier RAW un peu tristounet, il suggère plusieurs développements. Le module « correction rapide » délivre une image très réaliste. Le module « coucher de soleil » éclaircit l’image et en renforce les teintes chaudes. Le module « chutes de neige » fait ressortir la texture de la neige et la blanchit.

Jura (f/5.6 à 1/40 s) photo (C) J. Croizer

de gauche à droite et de haut en bas :

photo originale – correction rapide – coucher de soleil – chutes de neige

Ces modules agissent comme des modèles (effets prédéfinis) spécialisés. Certains donnent parfois des résultats un peu ésotériques, mais l’utilitaire d’édition permet de revenir finement sur les réglages en agissant sur les curseurs habituels (température de couleur, exposition, contraste, …) ou en jouant sur des notions plus contextuelles (brume, heure dorée, …). Lorsque le logiciel détecte que la photo est un portrait, il modifie ses propositions : Fashionista, Sublime, Rembrand… les styles prédéfinis (aux noms français parfois folkloriques…) ne manquent pas.

Plus intéressant, le module FaceAI détecte automatiquement le visage, en isole les yeux, les dents, les lèvres, la peau, et propose pour chaque partie des traitements adaptés. C’est sur ces aspects que le logiciel fera gagner le plus de temps, puisqu’il évite d’avoir à faire de fastidieuses sélections de zones. Notons qu’une fois classée l’image ou isolés certains de ces éléments, on retrouve dans l’utilitaire d’édition les techniques implémentées depuis déjà longtemps dans ce type de logiciel, ce qui n’enlève rien à ses qualités.

Pour aller plus loin dans l’analyse, il faudrait connaitre plus précisément les algorithmes de machine learning utilisés. Les éditeurs en gardent jalousement les secrets en ne communiquant que sur les résultats… et c’est bien naturel ! La mécanique mise en œuvre par l’étonnant outil « remplissage d’après le contenu » de Photoshop CC risque d’attiser longtemps la curiosité des développeurs.

Un bruit qui court

L’intelligence artificielle était donc finalement déjà présente depuis longtemps dans nos logiciels de post traitement, mais elle ne disait pas son nom. Ses derniers développements ont permis de proposer de nouvelles fonctionnalités spectaculaires, sans pour autant vraiment optimiser le temps de traitement des fichiers RAW. La quête de l’outil idéal risque d’être encore longue, mais ne boudons pas notre plaisir : si l’assistance à la conduite n’est pas la conduite autonome, elle procure néanmoins un confort d’utilisation très appréciable. A nous de débusquer dans toutes ses innovations celles qui nous seront vraiment utiles.

Prenons l’exemple d’un photographe qui travaillerait beaucoup avec des sensibilités élevées. Il ne pourra qu’être séduit par la dernière version du logiciel DxO Photolab 4. Depuis 2003, cette société teste des boitiers en photographiant dans son laboratoire des mires calibrées. Ces clichés, réalisés pas à pas sur toute la gamme de sensibilités du boitier, ont été conservés depuis l’origine, constituant un remarquable corpus d’apprentissage. Il a été mis à profit pour entrainer un module capable de réaliser simultanément le dématriçage et le débruitage des fichiers RAW pris en charge.

Les étonnantes capacités des réseaux de neurones convolutifs ont permis d’atteindre des résultats exceptionnels. Rappelons toutefois que ces puissants outils n’ont rien de la baguette magique d’Harry Potter. Mal entraînés, ils peuvent rapidement faire fausse route. L’erreur la plus fréquente est le surapprentissage : l’algorithme fonctionne parfaitement sur les images qui lui ont permis d’apprendre (c’est la moindre des choses !) mais il disjoncte dès qu’on lui présente une nouvelle image.

S’il est vrai que le fonctionnement des réseaux de neurones est comparable à celui de notre cerveau, il ne faut y voir qu’une mécanique en attente de l’artiste qui saura en agencer les couches et en régler les hyperparamètres, sous peine d’obtenir des résultats très aléatoires. Coup de chapeau donc aux analystes de données qui ont travaillé sur Photolab 4 pour nous proposer un résultat aussi abouti.

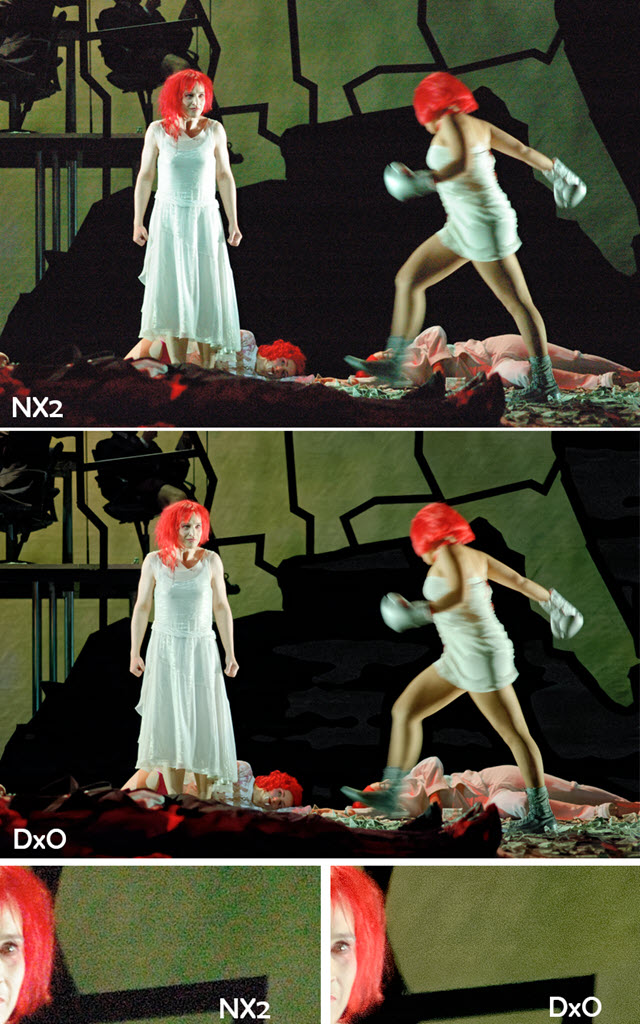

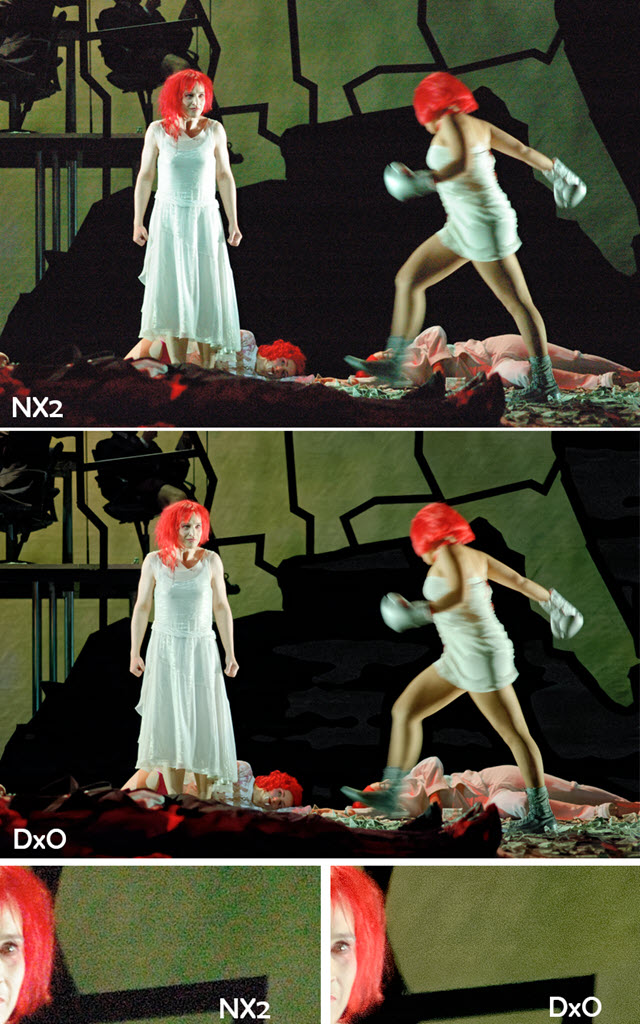

Plus que des mots, un exemple d’utilisation de la technologie DeepPrime de Photolab 4 devrait vous convaincre de ses capacités. La photo ci-dessous a été prise en 2006 au format RAW avec un Nikon D70, premier reflex numérique grand public de Nikon. Son logiciel de dématriçage était à l’époque « Capture NX2 ». Pour les besoins du test comparatif, le fichier a successivement été traité avec NX2 V2, puis Photolab 4. 12 années séparent ces deux logiciels.

Les 7 péchés capitaux (f/2.8 à 1/80 s) photo (C) J. Croizer

Dans la version Photolab, les teintes sont plus nuancées. Elles sont aussi plus détaillées dans les zones les plus saturées. Le bruit est très fortement atténué, sans pour autant lisser l’image. Voilà de quoi repousser les limites de nos appareils.

L’Intelligence artificielle en traitement d’image et photographie : en conclusion

Si l’intelligence artificielle est encore beaucoup utilisée comme un argument commercial, il apparait néanmoins que les avancées sont réelles dans les logiciels de post traitement.

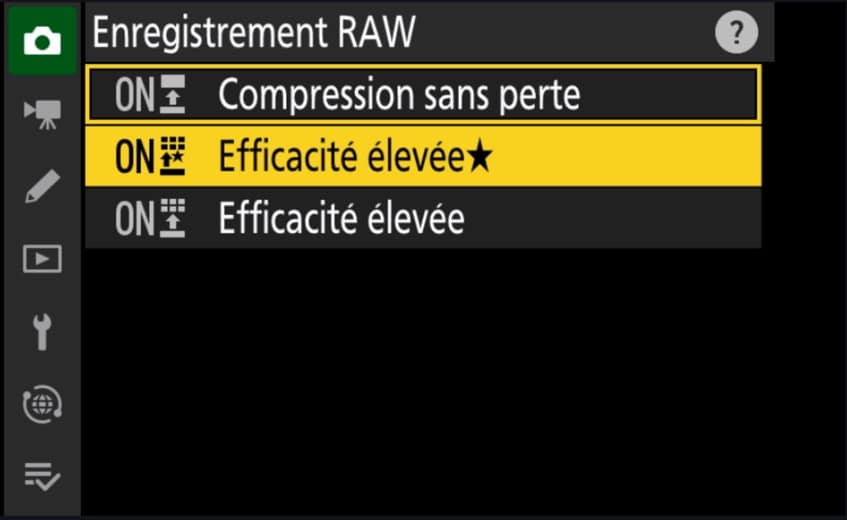

Vous doutiez encore de l’utilité des fichiers RAW ? Souvenez-vous qu’on y enregistre une seule donnée : la vérité, autrement dit la lumière renvoyée par la scène originale.

Nul doute que dans quelques années, vos logiciels préférés auront encore fait des progrès très impressionnants dans l’exploitation de cette information et qu’ils seront capables de magnifier vos archives. Alors surtout… gardez précieusement vos vieux RAW !

Le livre de Jacques Croizer via Amazon

Le livre de Jacques Croizer via la FNAC